Поскольку более быстрая и емкая память HBM3E должна появиться в сети в начале 2024 года, NVIDIA готовит свои серверные графические процессоры текущего поколения к использованию новой памяти. Еще в августе мы видели планы NVIDIA по выпуску версии суперчипа Grace Hopper GH200, оснащенной HBM3E, а теперь на выставке SC23 NVIDIA объявляет о своих планах вывести на рынок обновленную версию автономного ускорителя H100 с памятью HBM3E. , который компания будет называть H200.

Как и его аналог Grace Hopper, цель H200 — служить обновлением линейки продуктов Hx00 среднего поколения за счет выпуска версии чипа с более быстрой памятью и большей емкостью. Воспользовавшись памятью HBM3E, которую Micron и другие собираются внедрить, NVIDIA сможет предложить ускорители с более высокой реальной производительностью в рабочих нагрузках, ограниченных пропускной способностью памяти, а также компоненты, способные обрабатывать даже более крупные рабочие нагрузки. Это может быть особенно полезно в сфере генеративного искусственного интеллекта, которая до сих пор обеспечивала практически весь спрос на ускорители H100, поскольку самая большая из больших языковых моделей может максимально использовать H100 емкостью 80 ГБ.

Между тем, поскольку память HBM3E не будет поставляться до следующего года, NVIDIA воспользовалась перерывом, чтобы на досуге анонсировать обновленные детали HBM3E. После анонса GH200 этим летом анонс NVIDIA автономной версии ускорителя Hx00 с HBM3E был лишь вопросом времени, и на этой неделе NVIDIA наконец делает это объявление.

| Сравнение спецификаций ускорителей NVIDIA | |||||

| Н200 | Н100 | А100 (80 ГБ) | |||

| Ядра CUDA FP32 | 16896? | 16896 | 6912 | ||

| Тензорные ядра | 528? | 528 | 432 | ||

| Увеличение частоты | 1,83 ГГц? | 1,83 ГГц | 1,41 ГГц | ||

| Часы памяти | ~6,5 Гбит/с HBM3E | 5,24 Гбит/с HBM3 | 3,2 Гбит/с HBM2e | ||

| Ширина шины памяти | 6144-битный | 5120-битный | 5120-битный | ||

| Пропускная способность памяти | 4,8 ТБ/сек. | 3,35 ТБ/сек. | 2 ТБ/сек. | ||

| видеопамять | 141 ГБ | 80 ГБ | 80 ГБ | ||

| FP64 Вектор | 33,5 Тфлопс? | 33,5 терафлопс | 9,7 терафлопс | ||

| INT8 Тензор | ТОПС 1979 года? | 1979 ТОПС | 624 ТОПОВ | ||

| FP16 Тензор | 989 Тфлопс? | 989 терафлопс | 312 терафлопс | ||

| FP64 Тензор | 66,9 Тфлопс? | 66,9 терафлопс | 19,5 терафлопс | ||

| Межсоединение | НВЛинк 4 18 ссылок (900 ГБ/сек) |

НВЛинк 4 18 ссылок (900 ГБ/сек) |

НВЛинк 3 12 ссылок (600 ГБ/сек) |

||

| графический процессор | ГХ100 (814 мм2) |

ГХ100 (814 мм2) |

GA100 (826 мм2) |

||

| Количество транзисторов | 80Б | 80Б | 54.2Б | ||

| TDP | 700 Вт | 700 Вт | 400 Вт | ||

| Производственный процесс | ТСМЦ 4Н | ТСМЦ 4Н | ТСМЦ 7Н | ||

| Интерфейс | SXM5 | SXM5 | SXM4 | ||

| Архитектура | Хоппер | Хоппер | Ампер | ||

Основанная на том же графическом процессоре GH100, что и в оригинальном H100, новая версия ускорителя H100, оснащенная HBM3E, получит новый номер модели, H200, чтобы отличать ее от своего первоначального предшественника и согласовывать ее с суперчипом GH200 (чей Версия HBM3E не имеет отдельного номера модели).

Глядя на раскрытые сегодня спецификации, H200 по сути выглядит как Hopper-половина GH200, но с собственным ускорителем. Большая разница здесь, конечно, заключается в замене HBM3 на HBM3E, что позволяет NVIDIA увеличить как пропускную способность, так и емкость памяти, а также NVIDIA позволяет NVIDIA использовать 6й Стек памяти HBM, который был отключен в оригинальном H100. Это увеличит объем памяти H200 с 80 ГБ до 141 ГБ, а пропускную способность памяти с 3,35 ТБ/секунду до того, что NVIDIA предварительно ожидает на уровне 4,8 ТБ/секунду – увеличение пропускной способности примерно на 43%.

Если обратиться назад, основываясь на общей пропускной способности и ширине шины памяти, это означает, что память H200 будет работать со скоростью примерно 6,5 Гбит/с/контакт, что примерно на 25% выше по частоте по сравнению с исходной памятью HBM3 H100 с 5,3 Гбит/с/контакт. На самом деле это значительно ниже частот памяти, на которые рассчитан HBM3E — Micron хочет достичь скорости 9,2 Гбит/с на контакт — но, поскольку он модифицируется под существующую конструкцию графического процессора, неудивительно, что текущие контроллеры памяти NVIDIA не имеют такого же уровня. диапазон.

H200 также сохранит необычный объем памяти GH200 — 141 ГБ. Сама память HBM3E физически имеет емкость 144 ГБ (в виде шести стеков по 24 ГБ), однако NVIDIA удерживает часть этой емкости из соображений экономии. В результате клиенты не получают доступ ко всем 144 ГБ встроенной памяти, но по сравнению с H100 они получают доступ ко всем шести стекам с преимуществами емкости и пропускной способности памяти.

Как мы отмечали в прошлых статьях, для поставки детали со всеми шестью рабочими стеками потребуется, по сути, идеальный чип, поскольку спецификации H100 очень щедро позволяли NVIDIA поставлять детали с нефункциональным стеком. Таким образом, это, вероятно, будет меньший объем и меньшая производительность, чем сопоставимые ускорители H100 (которые уже в дефиците).

В остальном, ничто из того, что NVIDIA пока не раскрыло, не указывает на то, что H200 будет иметь лучшую вычислительную производительность, чем его предшественник. Хотя реальная производительность должна улучшиться благодаря изменениям в памяти, производительность FP8 в 32 PFLOPS, которую NVIDIA указывает для кластера HGX H200, идентична кластерам HGX H100, доступным сегодня на рынке.

Наконец, как и в случае с системами GH200, оснащенными HBM3E, NVIDIA ожидает, что ускорители H200 будут доступны во втором квартале 2024 года.

Анонсирован HGX H200: совместимость с системами H100

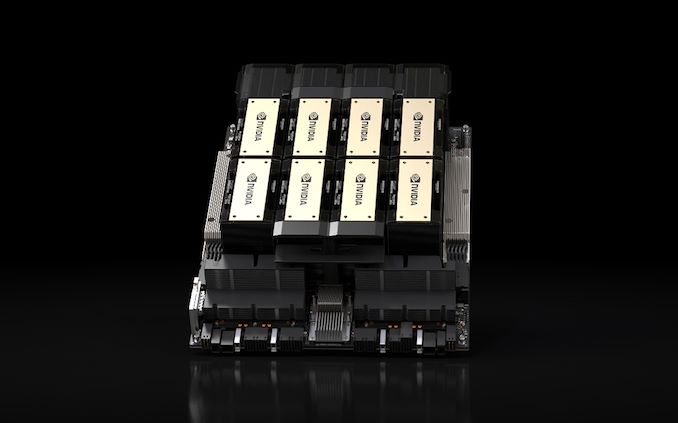

Наряду с ускорителем H200 NVIDIA также анонсирует свою платформу HGX H200, обновленную версию 8-процессорного HGX H100, использующую новый ускоритель. Настоящая основа семейства NVIDIA H100/H200, несущие платы HGX, содержат 8 ускорителей форм-фактора SXM, соединенных в заранее организованную, полностью связанную топологию. Автономный характер платы HGX позволяет подключать ее к подходящим хост-системам, что позволяет OEM-производителям настраивать части своих высокопроизводительных серверов, не связанные с графическими процессорами.

Учитывая, что HGX идет рука об руку с серверными ускорителями NVIDIA, анонс HGX 200 является во многом формальностью. Тем не менее, NVIDIA обязательно объявит об этом на SC23, а также позаботится о том, чтобы платы HGX 200 были перекрестно совместимы с платами H100. Таким образом, сборщики серверов могут использовать HGX H200 в своих текущих проектах, что делает переход относительно плавным.

Анонсирован Quad GH200: четыре GH200, объединенные в одну плату

Поскольку NVIDIA теперь массово поставляет чипы Grace и Hopper (и Grace Hopper), компания также анонсирует некоторые дополнительные продукты, использующие эти чипы. Последней из них является 4-полосная плата Grace Hopper GH200, которую NVIDIA называет просто Quad GH200.

В соответствии со своим названием, Quad GH200 размещает четыре ускорителя GH200 на одной плате, которую затем можно установить в более крупные системы. Отдельные платы GH200 соединены друг с другом в 8-микросхемной 4-канальной топологии NVLink, причем идея состоит в том, чтобы использовать эти платы в качестве строительных блоков для более крупных систем.

На практике Quad GH200 является аналогом Grace Hopper платформ HGX. Включение процессоров Grace технически делает каждую плату независимой и самоподдерживающейся, в отличие от плат HGX только с графическим процессором, но необходимость подключения их к хост-инфраструктуре остается неизменной.

Узел Quad GH200 будет предлагать 288 процессорных ядер Arm и 2,3 ТБ высокоскоростной памяти. Примечательно, что NVIDIA не упоминает здесь об использовании версии GH200 HBM3E (по крайней мере, изначально), поэтому эти цифры, похоже, соответствуют исходной версии HBM3. Это означает, что мы рассчитываем на 480 ГБ LPDDR5X на каждый процессор Grace и 96 ГБ HBM3 на каждый графический процессор Hopper. Или всего 1920 ГБ памяти LPDDR5X и 384 ГБ памяти HBM3.

Суперкомпьютер Jupiter: 24 тыс. компьютеров GH200 мощностью 18,2 мегаватт, установка в 2024 году

Наконец, сегодня утром NVIDIA объявляет о новой победе в разработке суперкомпьютера. Юпитер. По заказу совместного предприятия EuroHPC, Jupiter станет новым суперкомпьютером, состоящим из 23 762 узлов GH200. Как только он появится в сети, Jupiter станет крупнейшим суперкомпьютером на базе Hopper, анонсированным на данный момент, и первым, который явно (и публично) ориентирован на стандартные рабочие нагрузки HPC, а также на низкоточные рабочие нагрузки тензорного искусственного интеллекта, которые стали определить первые суперкомпьютеры на базе Хоппера.

Юпитер, заключенный по контракту с Eviden и ParTec, представляет собой во всех отношениях демонстрацию технологий NVIDIA. Ядро суперкомпьютера основано на узле Quad GH200, который NVIDIA также анонсирует сегодня, процессоры Grace и графические процессоры Hopper. Отдельные узлы поддерживаются сетью Quantum-2 InfiniBand, несомненно, основанной на адаптерах NVIDIA ConnectX.

Компания не раскрывает конкретные цифры количества ядер или объема памяти, но, поскольку мы знаем, что предлагает одна плата Quad GH200, математика достаточно проста. В верхнем пределе (при условии отсутствия утилизации/группировки по соображениям доходности) это будут 23 762 процессора Grace, 23 762 графических процессора класса Hopper H100 и примерно 10,9 ПБ LPDDR5X и еще 2,2 ПБ памяти HBM3.

Планируется, что система будет обеспечивать производительность низкой точности 93 EFLOPS для использования в сфере искусственного интеллекта или более 1 EFLOPS производительности высокой точности (FP64) для традиционных рабочих нагрузок HPC. Последняя цифра особенно примечательна, поскольку это сделает Jupiter первой экзафлопсной системой на базе NVIDIA для рабочих нагрузок HPC.

Тем не менее, к заявлениям NVIDIA о производительности HPC следует относиться с осторожностью, поскольку NVIDIA все еще учитывает здесь тензорную производительность: 1 EFLOPS FP64 — это то, что 23 762 H100 могут обеспечить только с тензорными операциями FP64. Традиционным показателем теоретической производительности суперкомпьютера HPC является векторная производительность, а не производительность матрицы, поэтому этот показатель не совсем сопоставим с другими системами. Тем не менее, поскольку рабочие нагрузки HPC также частично используют матричную математику, это утверждение также не является совершенно неуместным. В противном случае для тех, кто ищет обязательное сравнение с Frontier, производительность Юпитера в прямом векторе составит около 800 терафлопс, тогда как у Frontier более чем в два раза выше. С другой стороны, насколько близки эти две системы в реальных условиях, будет зависеть от того, насколько много матричной математики используется в их соответствующих рабочих нагрузках (результаты LINPACK должны быть интересными).

Цена на систему не объявлена, но энергопотребление есть: 18,2 мегаватта электроэнергии (~ на 3 МВт меньше, чем у Frontier). Таким образом, какова бы ни была истинная цена системы, как и сама система, она не будет миниатюрной.

Согласно пресс-релизу NVIDIA, система будет размещена на предприятии Forschungszentrum Jülich в Германии, где она будет использоваться для «создания фундаментальных моделей искусственного интеллекта в исследованиях климата и погоды, материаловедении, открытии лекарств, промышленном проектировании и квантовых вычислениях». » Установка системы запланирована на 2024 год, однако дата, когда она появится в сети, не объявлена.

www.anandtech.com